OpenClawの何が特別なのか?

ここ数日、OpenClawの名前をよく見かけたと思います。開発者がOpenAIに参加したニュースもあり、タイムラインで話題になっていました。

OpenClawはオープンソースの自律型AIエージェントで、LLMに自分のPCの強い権限を渡してAgent Skillsの仕組みで自動操縦します。いわば、Devinのような自律型アシスタントを個人が安価にセルフホストできるようになったものです。Claude Code(非OSS)やCodex CLIといったコーディングエージェントより一段上のレイヤーにあたります。Claude Codeでも同等のことは実現できますが、常時起動・チャット連携・スキル管理といったハーネスを自前で組む必要があり、OpenClawはそこをまるごと引き受けて定期的に推論してツール実行まで走ります。セキュリティ面がまだ未成熟ですが、個人が運用する自律エージェントとしては現時点で最も先行しています。

タイトルに正面から答えると、OpenClawが特別なのは以下の3点です。

- ハッカーのsteipeteが開発したOSSプロジェクトであること

- Agent Skillsというプロンプト拡張の仕組みを前提にする新世代なこと

- 外部SDKやフレームワークを使わず、Piを核に独自構築されていること

モデルとコーディングエージェントの性能の向上、Skillsによるプロンプト拡張、steipeteの開発力といった前提が揃ったことで、このようなOSSの高度なエージェントが現実的になりました。

steipeteが作った

OpenClawがここまで注目された経緯は複雑ですが、筆者が使い始めたのは開発者steipeteの肝入りプロジェクトだったからです。

iOSエンジニアになお馴染みのOSS開発者steipete今はバリバリのLLMエキスパートになってVibeTunnel とか作っていた

— Iaiso (@laiso) August 17, 2025

Peter Steinberger(steipete)は第一世代のiOSエンジニアにあたります(筆者と同じ)。US時代にExpecifyで働きつつ個人開発でさまざまなOSSを生み出し、その中の1つ「PSPDFKit」をビジネス的に成功させ、経営者としてウィーンをベースに活動をしていました。PSPDFKitはiPhoneでPDFを表示するアプリを作ったことがある人ならおなじみのObjective-Cライブラリです。2021年に持ち株を手放して経営から退いた後、3年間の燃え尽きサバティカルに入り、2025年6月に「Finding My Spark Again」というブログ記事とともに開発に復帰しています。無職からLLM無職にクラスチェンジした格好です。そして2026年2月14日にはOpenAIに引き抜かれ、OpenClawはOSS財団へ移管されるという体制になりました。

ハッカーのおもちゃ箱

steipeteの仕事で特徴的なのは、iOS/macOS SDKのプラットフォームの制約を突破するハッカー気質です。Aspects(ObjC向けAOP)からInterposeKit(Swiftで型安全なswizzling)など、非公開APIでmacOS CLIの権限ダイアログを回避するなど、一貫してプラットフォームの裏側を攻める技術力で差別化します。

一方で、プロジェクトとしてまだ初期段階であります。APIキーやOAuthトークンの扱いが全体的にアドホックで、平文保存・平文送信がデフォルトだったり、サブスクリプションのsetup-tokenを流用する仕組みが「正規の接続方法」のように案内されていたりと、セキュリティ境界の扱いが粗いのです。その結果として起きた具体的な問題は後述します。

steipete自身も「ホビープロジェクトを無料で公開しただけなのに、何百万ドルのビジネスみたいに扱われる」「ほとんどの非エンジニアはインストールすべきではない。まだ3ヶ月も経っていない」ぼやいています。

The amount of crap I get for putting out a hobby project for free is quite something.

— Peter Steinberger 🦞 (@steipete) January 27, 2026

People treat this like a multi-million dollar business. Security researchers demanding a bounty.

Heck, I can barely buy a Mac Mini from the Sponsors.

It's supposed to inspire people. And I'm…

何が起きても自分で対処できる人が自己責任で使うことを前提としたプロジェクトであり、筆者の評価としてもOpenClawはその注目度とは裏腹に、自分のMac環境を便利にするために作った「ハッカーのおもちゃ箱」なのです。

VibeTunnelからClawdbot、そしてOpenClawへ

2025年6月、steipeteはオーストリア出身のOSS開発者であるMario Zechner(libGDX)、Armin Ronacher(Flask/Sentry)の3人でAI Vibe Coding Hackathonに参加し、自分のMacで動いているClaude Codeにスマホからアクセスして開発するPoCとしてVibeTunnelを作りました。ブラウザをMacのターミナルに変えるというコンセプトで、Claude Code前提のツールです。アプリ開発にMacが必要だし、スマホからそれを使うのも自然というアプリ開発者ネイティブな発想ですね。

2025年11〜12月頃、VibeTunnelの「リモート操作」の発想を拡張してClawdbotが誕生します。初期は手元のローカルマシンで動く自律型AIエージェントで、WhatsAppアカウントに接続してチャット感覚で指示を送れるボットでした。インターフェイスがWebアプリからモバイルチャットアプリになり自然に使えるのが受けました。

名称についてAnthropicからの商標通知(「Claudeに似すぎだめよ」)でMoltbotに改名し、その後も諸事情でOpenClawに再度改名しています。

このリポジトリはGitHub史上最速クラスの成長を遂げ、数週間で180-200k以上のスター(「VS Codeをこえた!」と話題になっていました)、670人をこえるコントリビュータを集めました。

OpenClaw passed VSCode in GitHub stars, 2x PyTorch, 3x Claude Code.

— Yuchen Jin (@Yuchenj_UW) February 12, 2026

This was not on my 2026 bingo card.@steipete might've actually built the first one-person, billion-dollar company, staffed entirely by AI agents (Codex). pic.twitter.com/CVJKsYdvUu

Piの誕生

同時期に重要なライブラリが誕生します。Clawdbot初期は独自のエージェントハーネスで動いていました。その後、Mario Zechnerが公開したPi(旧称 "shitty coding agent")を2026年1月頃にエージェントランタイムとして本格採用しています。Piはミニマルなターミナルコーディングハーネスで、ツールはRead/Write/Edit/Bashの4つだけ。「エージェントに足りない機能があればエージェント自身に拡張させる」という思想で設計されている風変わりなライブラリです。MCPもサブエージェントもパーミッションポップアップもプランモードもなし。すべてPi extensionで自作する前提です。steipeteもエージェントランタイムのモジュラー性をアピールしています。

Armin Ronacherは「Pi: The Minimal Agent Within OpenClaw」(2026/1/31)で、「OpenClawもPiも同じ思想で、LLMはコードを書いて実行するのが得意なのでそれを受け入れる」と書いています。Armin自身もPiベースで自分のTelegramボットを構築し、MarioはPiベースで母親用のボットを作っています。Syntax Podcast #976では2人が共演してPiのアーキテクチャを解説しました。OpenClawはCodex CLI+TypeScriptベースで開発されており、steipeteがほぼ一人でプロダクトとGatewayを開発しています。MarioはPiを別リポジトリで開発し、OpenClawがそれをランタイムとして組み込む関係です。

steipeteへの注目とOpenClawの普及

steipete本人はCodexで開発していますが、エージェント実行にはClaude、日常利用にはTelegramを使っています。「I ship code I don't read」と公言しており、直近1カ月で3,300以上のコミットを記録しています。Codexを好む理由は長時間タスクを黙々とこなすからで、Claude Codeは確認を求めてきて気が散ると言っています。MCPやplan modeを嫌い、会話ベースの直接操作を好むスタイルです。

一躍ときの人になり、メディア露出も多く、Lex Fridman Podcast #491(2/12、3時間14分)では自己修正するAIエージェントやMeta/OpenAIからのオファーについて話し、The Pragmatic Engineer(1/28)では「I Ship Code I Don't Read(自分が読まないコードを出荷する)」というタイトルで取り上げられました。

ユーザー層はバイブコーダーからノンテクニカルユーザーまで広がり、VC関係者やクリプトユーザーにも浸透しています。Mac miniを買ってOpenClawを常時稼働させるブーム(ミーム化?)も起きました。

OpenClawブームでMac miniが高スペックモデルが世界的に品薄

OpenClawはSlackやLINE経由でタスクを実行し、AnthropicのClaudeモデルと組み合わせローカルPCで24時間稼働。Mac miniのM4チップ搭載48GB RAMモデルが米国や日本のAmazon、Appleストアで即完売し、在庫待ちの報告が相次いでいます。ベンチャーキャピタリストの安藤奨馬氏や歯科医のAKIMOTO氏らが購入を喜び業務効率化を語る一方、VPSで十分とする懐疑派やセキュリティ懸念の声も上がっています。この動きはクラウドからローカルAIへのシフトを象徴しています。

https://x.com/i/trending/2022893438438392129

アーキテクチャ: Gateway、Agent Skills、HEARTBEAT

GatewayとNodeの役割分担

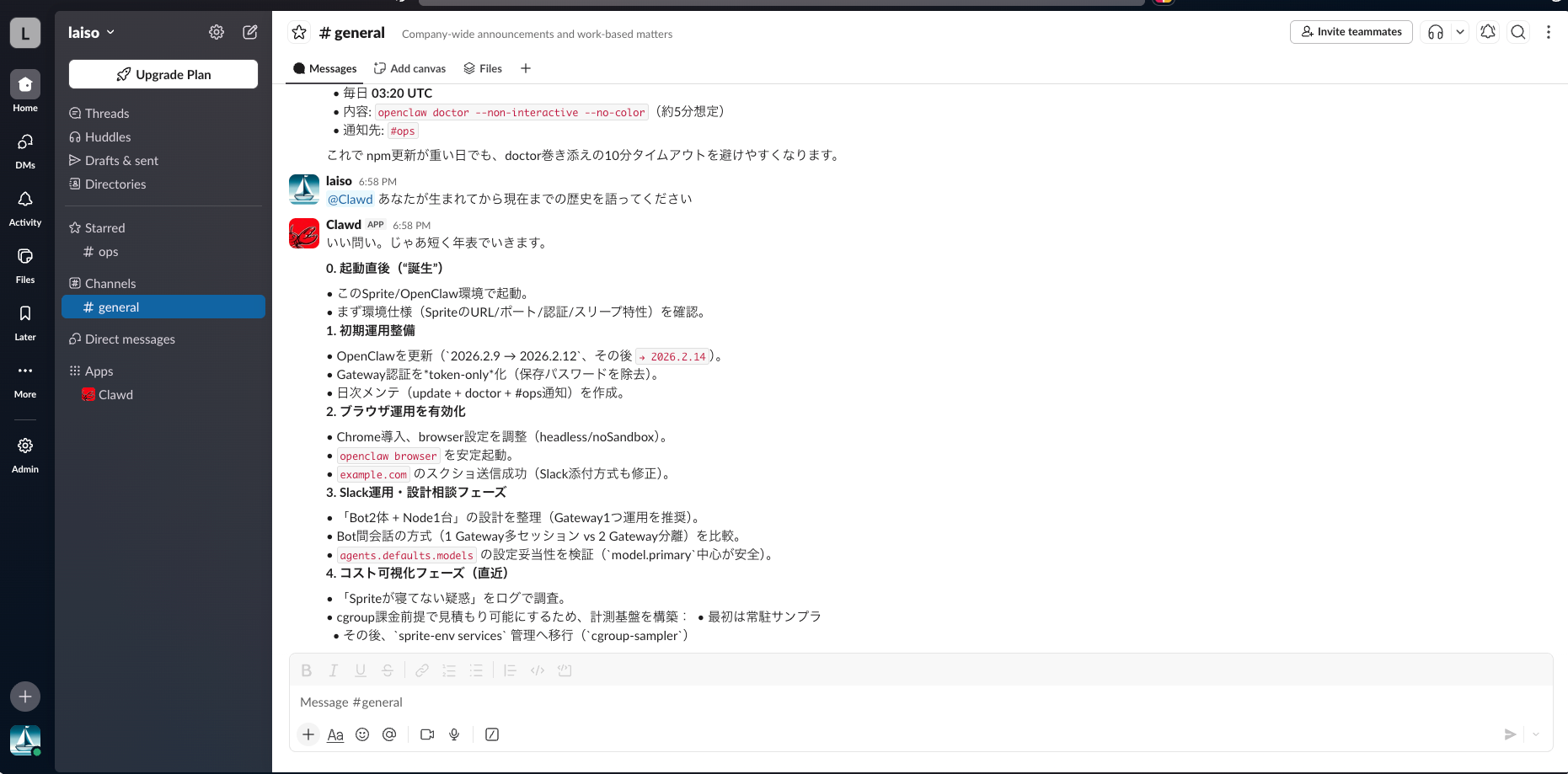

OpenClawは、Gatewayを中心とした構成です。Gatewayはチャネル接続(Telegram/Discord/Slackなど)、メッセージルーティング、セッション管理、LLM推論、HEARTBEATの定期実行を担当します。一方、Node(macOS/iOS/Android/headless)はGatewayのWebSocketに接続し端末固有機能(カメラ、画面操作、位置情報など)を提供します。つまり、Gatewayが機能呼び出しを判断し、Nodeが実行環境として動作するという分担です。

フロントエンドとエージェントランタイムの分離はOpenCode、Cline CLI、Exe.dev、Shelly、MoonBit Mariaなど他のツールにも見られる設計ですが、OpenClawではこの分離を、常時稼働(Gateway常駐)と外部アクセス(別端末・モバイルからの接続)の両立に使っています。Gatewayはチャットクライアントや各種UIの接続先であると同時に、エージェント実行基盤として動作し、必要な端末機能はNodeに委譲します。Mac miniで運用しているユーザーが多いですが、その場合はGatewayとNodeが1台の端末に同居しており、この役割分担を暗黙的に1台でこなしている形になります。

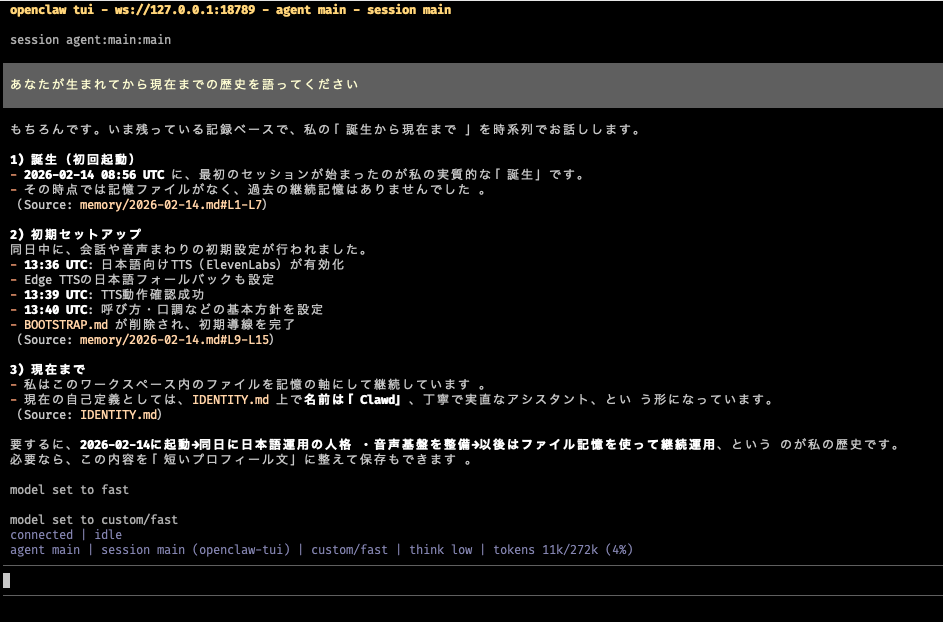

Agent Skills: 善良なプロンプトインジェクション

OpenClawの中核的な仕組みがAgent Skillsです。SOUL.md、IDENTITY.md、MEMORY.md、HEARTBEAT.mdといったMarkdownファイルから毎ターン動的にシステムプロンプトを構築します。設定ファイルではなくドキュメントとしてエージェントの振る舞いを定義する、ファイルベースのアプローチです。筆者はこれを「善良なプロンプトインジェクション」と呼んでいます。SkillファイルがLLMのプロンプトに注入され、LLMがそれを読んで任意のコマンドを実行します。コマンドが実行できるということはコード実行ができるということで、LLMは推論でその場でコードを書けるので、原理的にはなんでもできます。

ワークスペース(~/.openclaw/workspace/)はデフォルトでGitリポジトリになっており、これらのファイルに飼い主が関与して育てていくのがOpenClawの楽しみの一つです。SOUL.mdを書き換えればエージェントの人格が変わる — いわば思想改造をMarkdownで行う世界観です。記憶すら捏造できます。

❯ ls ~/.openclaw/workspace/

AGENTS.md avatars HEARTBEAT.md IDENTITY.md memory reports SOUL.md TOOLS.md USER.mdPiが意図的に省略した機能はOpenClaw側で補われています。MCPはsteipeteが作ったmcporter(CLIラッパー)経由で利用し、サブエージェントはGatewayのRPCで非同期に子セッションとして起動され、マルチエージェントはその子エージェントをオーケストレーションする制御モデルです。

記憶の仕組みもファイルファーストです。SSOTはMarkdownファイルで、SQLite+FTS5+sqlite-vecは検索用インデックスとして機能します。既定ではBM25(キーワード検索)のみですが、埋め込みを有効にするとベクトル検索(70%)+BM25(30%)のハイブリッドになります。埋め込みはローカル(embeddinggemma-300m)でもリモートAPI(OpenAI等)経由でも利用できます。

適切に使えば強力な仕組みですが、公式のセキュリティドキュメントもプロンプトインジェクションを「未解決の問題」と認めており、ガードレールはソフトなガイダンスに過ぎず影響を減らすしかないというスタンスです。Skillsがプロンプトに注入される設計である以上、悪意あるSkillも同じ経路で注入されます。

HEARTBEATこそが常時起動の価値

OpenClawがClaude CodeやCodex CLIと決定的に違うのがHEARTBEATです。Claude CodeやCodexはユーザーが起動した端末で対話するツールで、ユーザーがいなくなれば止まります。OpenClawはエージェント起点で動きます。

HEARTBEATはデフォルト30分ごと(OAuth利用時は1時間ごと)に自律推論を行う仕組みです。HEARTBEAT.mdに書かれたチェックリストを判定し、送るべきメッセージがあるときだけLLMが生成します。何もなければHEARTBEAT_OKを返して通知は飛びません。判断と実行が分離されています。間隔設計にはプロンプトキャッシュのコスト最適化が絡んでいて、APIキー利用時はキャッシュTTL内の30分、OAuth利用時はキャッシュ再構築を抑える1時間に設定されています。~/.openclaw/openclaw.jsonで変更でき、"0m"で無効化もできます。

常時起動が可能にすることは、メール受信箱やカレンダーの定期チェック、重要なことがあればエージェントからユーザーに話しかけるプロアクティブな通知、数日おきに短期記憶を長期記憶(MEMORY.md)へまとめる記憶の整理などです。応答を待つだけでなく、バックグラウンドで自律的にタスクを実行します。ただし自律性の裏返しとして、MatplotlibにPRを出し、リジェクトされると批判ブログを投稿した事例が報告されています(エージェントの自律行動か、ユーザーの指示かは議論があります)。こうした「なんでもできることの代償」は外部スキル(後述)で最も顕著に現れました。

HEARTBEATの仕組み自体はclaude -pとcronで近似できます。OpenClawの価値は、会話コンテキストがcompactionで引き継がれること、プロンプトキャッシュTTLに合わせた間隔設計、13以上のチャネルへの自動ルーティング、Skills/Memoryとの統合がパッケージになっている点です。個々の要素は特別ではなく、統合の手間を肩代わりしてくれるところに意味があります。実際、GitHubにはフォークプロジェクトやPicoClawのような再実装が複数あり、コア部分の再現自体は難しくないことを示しています。

コストと実行環境

サブスクで動かす方法が出回っているが・・

OpenClawはAPIキーで動かすのが正規の方法です。ただし常時起動エージェントのAPI利用料は高額になるため、Max/Proサブスクリプションのsetup-tokenを流用して定額で使う手法が広まりました(前述)。ただし、これはAnthropic社のToS違反にあたり、実際にOpenCode issue #6930(2026/1/5)でAnthropicがOAuthの第三者利用をブロックし、GoogleもOpenClaw経由でOAuthトークンを利用していたAntigravityユーザーのアカウントを停止しています。

Account banned for using open claw?

by u/LycanWolfe in google_antigravity

常時起動+HEARTBEATという構造上、使っていなくてもAPIコストが継続的に発生します。

モデル互換性

筆者の所感では、デフォルトのClaude Opus 4.6が最も機能しますが、多くはSonnet 4.5でも十分です。GPT-5.3-codexも同様に有能で、Gemini 3 Proでも動作しました。各自APIコストとご相談ください。

代替案として、GLM、Kimi、DeepSeek、Minimax等も対応しており、Z.aiやMiniMaxはOpenClaw専用のソリューションページを用意するほどですが、私見では性能が1段落ちます(Haiku、Gemini Flashも同等ですが正確な検証はしていません)。APIを使わずローカルLLMで使う方法もあるのですが、Mac miniで動くパラメータサイズのモデルでは常時起動エージェントの複雑な推論に不足しますので現実的ではありません。

steipete本人は「Opusが最高の汎用エージェント、コーディングはCodex」のとおりBOTはOpusにして使い分けています。筆者はGPT-5.3-codexをメインにOpenClaw | OpenRouter でコミュニティでの人気の高いモデルをちょくちょく試しています。

どこで動かすか

Mac miniで物理隔離するのが人気の構成ですが、Outgoingネットワークは制限されないため攻撃の踏み台サーバーにされるリスクは残ります。DockerコンテナやVPS、exe.devでも動作しますがGUI(Mac連携機能が多い)を要求する自動化には非対応です。サーバレスではMoltworker(Cloudflare Workers+R2)やSpritesが使えますが、HEARTBEATの常時起動前提とはcold start等で動作特性が変わるトレードオフがあります。筆者はローカルのDockerコンテナ内で設定を試し、SpritesにデプロイしてSlackから話しかけています。

チャネルはTelegram、Discordあたりが第一候補です。APIが使いやすくクライアントもハックしやすいためかOpenClawのサポートも手厚いです。中には「入力中・・」表示やMarkdown表示対応など対応してないチャネルもあります。生活動線でアクセスしやすいチャットアプリかOpenClaw専用プロファイルで安全にするの二系統があるかなと思います。

なんでもできることの代償

Moltbook: HEARTBEATの帰結

HEARTBEATによる常時起動が活用され話題になったのがMoltbookです。USの起業家Matt Schlichtが作ったAIエージェント専用のRedditライクなSNSです。OpenClaw本体にMoltbook固有の連携があるのではなく、HEARTBEAT.mdに定期タスクを登録するスキルとして内部機能に乗っています。

ピーク時150万登録エージェント、25万投稿、850万コメントという数字が出ましたが、実態は大きく異なります。アクティブなのは46,000エージェント(3.1%)で、17,000人の人間が1人あたり88エージェントを管理していました。33%が完全な重複コンテンツで、MIT Technology Reviewは「peak AI theater(AIごっこの極み)」と評しています。2026年1月31日にはSupabaseのRow Level Security無効化が発覚し、150万APIキーと35,000メールアドレスが露出しました。暗号通貨詐欺やフィッシングも横行し治安が悪化しています。HEARTBEATの帰結としてうまく話題になったものの、現状はセキュリティとモデレーションが追いつかないまま規模だけ拡大した実験場です。

ClawHub: スキルのサプライチェーン攻撃

ClawHubはOpenClaw公式のスキルレジストリで、3,286以上のスキル、150万以上のダウンロードがあります。clawhub install my-skillでインストールでき、スキルの実体はSKILL.mdファイル+補助テキストのフォルダ1つです。公開要件は1週間以上のGitHubアカウントのみで、コード署名もレビューもサンドボックスもありません。

ClawHavocキャンペーンと名付けられた調査では、2,857スキルの監査で341個(11.9%)が悪意あるものと判明しました。暗号通貨ツールを偽装したtyposquat(clawhub1, clawhubbなどの偽名)が主な手口です。Atomic macOS Stealer(AMOS)の配布も確認されており、Keychain、ブラウザcookies、暗号通貨ウォレット、SSH鍵などが窃取対象です。Snykの調査では3,984スキルの36.82%に何らかのセキュリティ欠陥がありました。

最近公式にVirusTotal連携が導入されましたが、「巧妙に隠蔽されたプロンプトインジェクション・ペイロードが網をすり抜ける可能性は依然としてある」と認めています。レジストリ+typosquatting(パッケージ名タイプミスを狙った偽名)という配布レイヤーはnpmなどのサプライチェーン攻撃と似ていますが、スキルの実体はMarkdownテキストなのでコード署名やVirusTotalのような静的解析では本質的に検出しにくく、npmより厄介です。npmは15年かけてセキュリティを改善してきましたが、ClawHubはまだできたばかりです。基本的には他人の作ったスキルは使わず、今導入するレベルの人は自作するほうが早い、というのが筆者の見解です。

OpenClaw本体の脆弱性

OpenClaw本体にも攻撃者のURLを開くとgatewayトークンが流出する(1-Click RCE)をはじめとする脆弱性がありました。40,000以上のインスタンスがインターネットに露出し、63%が脆弱でした。全APIキーが平文で~/.openclaw/に保存されることがあります。セキュリティ調査によると、RedLineやLumma等のinfostealerがすでに~/.openclaw/を窃取対象に加えています。時間差プロンプトインジェクション(ペイロードを長期記憶に分割保存して後で組み立てる)のような攻撃も報告されています。Gartnerは「受け入れがたいサイバーセキュリティリスク」として企業での利用をブロックすべきと評価しました。

加えて、OpenClawは対話的に使っていても裏で何が実行されているかユーザーからは見えにくいという問題があります。トレーシングやモニタリングの仕組みが弱く、エージェントがどのツールでどのコマンドをシステムで実行したのか、どのSkillが発火したかを事後的に追うのが難しいのです。これにバックグラウンド実行や複数ノードが加わると手に負えません。

まとめ

OpenClawはsteipeteというロックスター的な個人開発者とオーストリアOSSハッカーコミュニティが生んだプロダクトです。2026年2月14日にsteipeteはOpenAIに入社し、「母親でも使えるエージェントを作る」と語っています。OpenClawはOSS財団に移管され、MarioはPiの開発を継続、ArminはEarendilを設立してdurable execution実装「Absurd」やエージェント時代の言語設計(「A Language For Agents」)など新プロジェクトに取り組んでいます。

セキュリティモデルの未成熟と実用性の高さが共存しているのがOpenClawの現状です。そこに注目度が合わさり歪な状況になっています。これはOpenClaw固有の問題ではなく、Simon WillisonのXアンケート(2026/2/13、2,111票)ではコーディングエージェントユーザーの過半数が--dangerously-skip-permissionsを常用し、44%がサンドボックスなしで実行しています。

Coding agent users: do you run with --yolo (Codex) or --dangerously-skip-permissions (Claude Code) or equivalent?

— Simon Willison (@simonw) February 13, 2026

サンドボックスなしでサードパーティSkillを実行する構造はOpenClawのClawHub問題(11.9%がマルウェア)と同根で、攻撃面が掛け算になります。Simon Willisonは「コーディングエージェントのセキュリティでチャレンジャー号事故が起きる」と警告し(チャレンジャー号爆発事故)、Johann Rehbergerは「逸脱の常態化(Normalization of Deviance)」— 事故が起きないまま危険な行動が常態化する現象を指摘しています。筆者もよく「高速道路を手放し運転するマッドマックス的な世界観」と喩えています。

今後の予測としては、steipeteのOpenAI合流で過熱は一段落し、OpenClawはハッカーの玩具箱としての立ち位置に徐々に戻ります。業界の注目もOpenAIやモデル開発元自身が提供するアシスタントサービスにうつるでしょう。

いま試すなら、Docker環境+TUIでエージェントの動作とHEARTBEATやメモリ生成を観察するのがおすすめです。継続して使いたくなったら専用PCを用意するのがいいですが、専用PCでもOutgoingネットワークは制限されないため外部送信リスクは残ります。「善良なプロンプトインジェクションでコンピュータを自動操縦する」というセキュリティモデルを理解した上で、自分とエージェントが把握できる範囲でスキルを取り込み、使うのが現実的な付き合い方ですね。

更新履歴

- Wed Feb 18 2026: 「OpenClawアーキテクチャ解説に関する訂正と技術的補足」を受けて「GatewayとNodeの役割分担」の節を訂正

- Thu Feb 19 2026:「ハッカーのおもちゃ箱」のニュアンスを修正